Dies ist kein gewöhnlicher Blogbeitrag. Heute präsentieren wir Ihnen stattdessen ein kurzes Video-Tutorial. 🎥

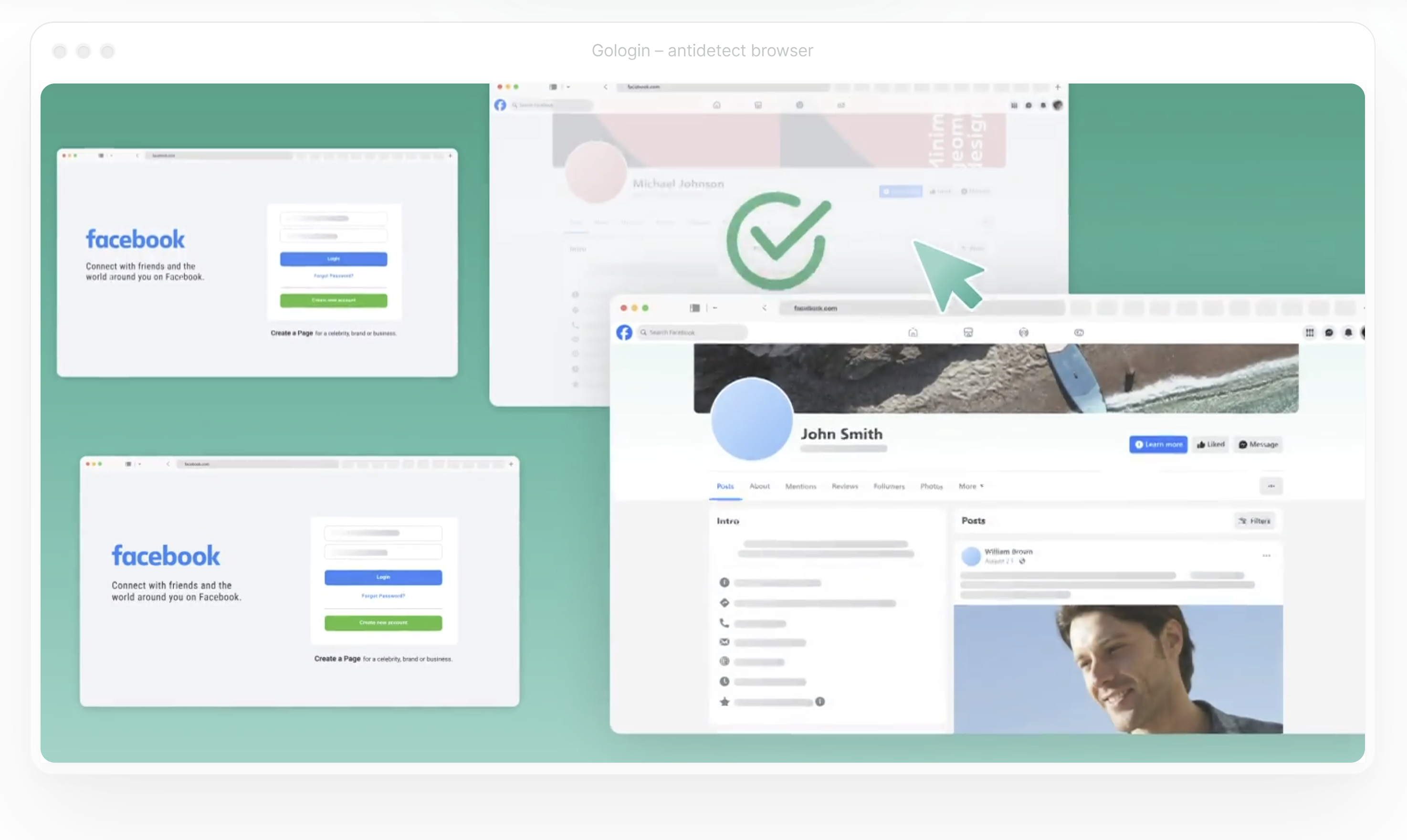

In diesem Video zeigen wir Ihnen Schritt für Schritt, wie Sie Proxys in Gologin einrichten. Sie erfahren, wie Sie eine Verbindung zu einem zuverlässigen Proxy herstellen (mit ProxyScrape als Beispiel), Ihre Einrichtung zu testen und Ihre Browsersitzungen anonym zu gestalten.